Blogs

Waarom 95% van AI-projecten faalt (en wat de 5% anders doet)

De cijfers liegen niet: volgens MIT-onderzoek haalt slechts 5% van AI-pilots de productie met meetbare impact. Niet omdat de technologie niet werkt—maar omdat organisaties dezelfde fout blijven maken.

En die fout zit 'm niet waar je denkt.

Het probleem dat niemand benoemt: AI leert niet vanzelf

Nieuwe medewerkers worden na een paar maanden steeds beter. Ze vangen signalen op, passen zich aan, leren van feedback.

AI doet dat niet.

Een AI-assistent presteert op dag 180 exact hetzelfde als op dag 1, tenzij iemand actief die feedback loop onderhoudt. MIT noemt dit de learning gap: het verschil tussen hoe mensen leren en hoe AI-tools stagneren zonder begeleiding.

Bij een verzekeraar losten we dit op door samen met de mensen die het werk doen het proces uit te tekenen. Wat is de input? Wat is de verwachte output? Daarna iteratief de prompts aanpassen, mét die mensen aan tafel.

Het resultaat: een AI-assistent die hun standaard haalt. Omdat zij bepaalden wat die standaard is.

Bij een zorginstelling sloegen we die stap over. Mensen gingen met te hoge verwachtingen aan de slag, de kwaliteit viel tegen, en ze haakten af.

Dezelfde technologie. Compleet ander resultaat.

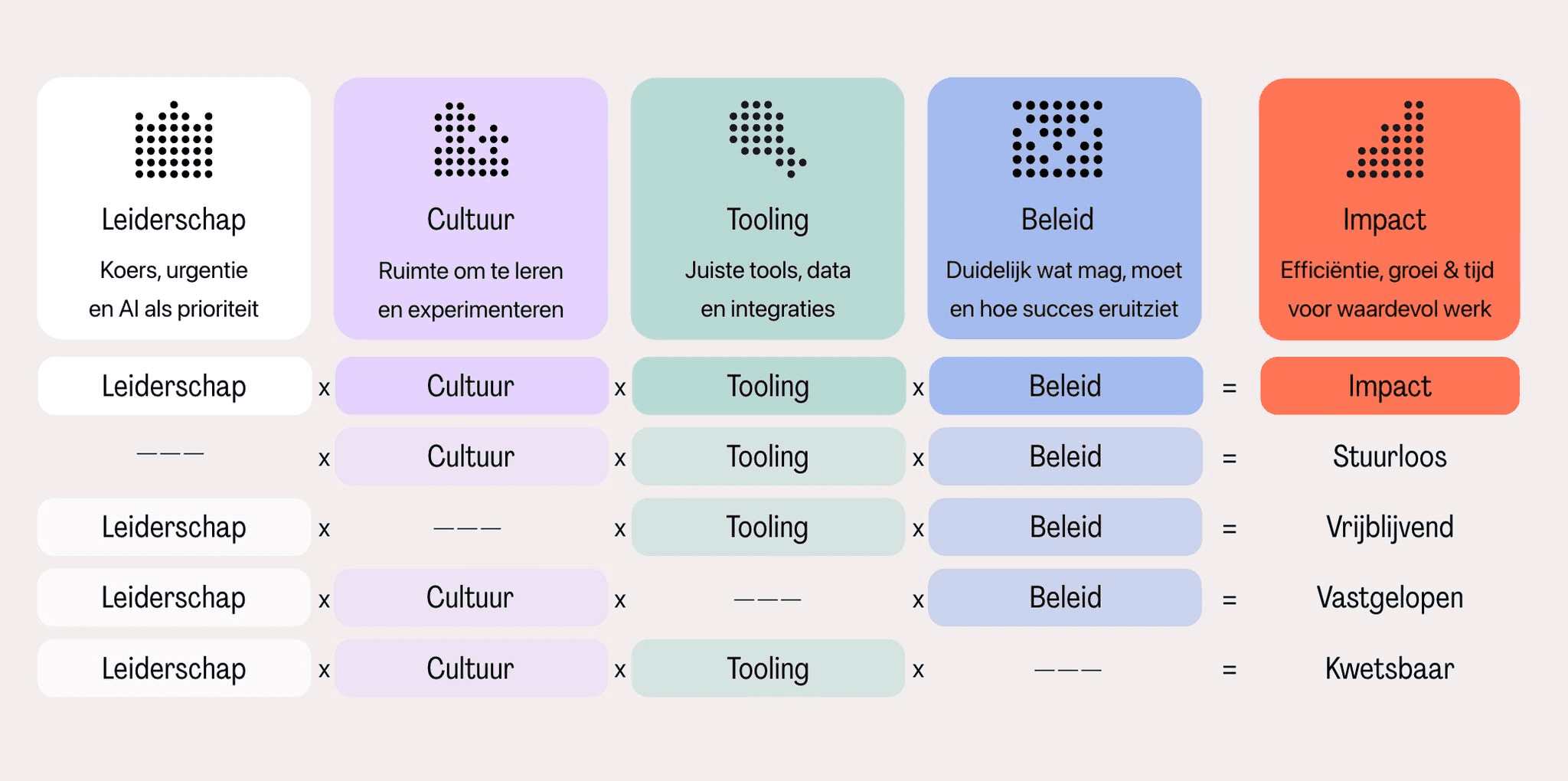

Vijf factoren die bepalen of AI-implementatie slaagt

Succesvolle AI-adoptie vraagt om vijf elementen. Niet drie van de vijf—alle vijf.

1. Leiderschap

Niet alleen budget vrijmaken, maar actief betrokken zijn. Vragen stellen. Voortgang volgen. Blokkades weghalen.

2. Cultuur

Ruimte om te experimenteren. Fouten mogen maken zonder afgerekend te worden. "Ik heb iets geprobeerd met AI en het werkte niet" moet een geaccepteerde zin zijn.

3. Tooling

De juiste technische basis. Toegang tot data. Systemen die met elkaar praten. Dit is waar de meeste organisaties beginnen—maar het is slechts één van vijf.

4. Beleid

Hier gaat het meestal mis. Wat betekent het concreet als iemand "goed met AI werkt"? Hoe meet je dat? Hoe beloon je het? Zonder antwoorden op die vragen blijft AI een hobby in plaats van een werkwijze.

5. Impact

Meetbare resultaten die het verhaal vertellen. Niet "we besparen tijd" maar "dit proces kostte 4 uur, nu 45 minuten." Cijfers die je kunt delen.

Mist er één factor? Dan krijg je pilots die eeuwig pilot blijven.

Waar het écht vastloopt

Je zou denken: technologie. Of budget. Of weerstand van medewerkers. Maar wat we het vaakst zien is anders.

Leiderschap maakt er prioriteit van. De cultuur is er klaar voor. De tools werken. Mensen zijn enthousiast. En dan stokt het bij beleid.

Want niemand heeft gedefinieerd wat "goed AI-gebruik" betekent. Er is geen manier om het te meten. Geen manier om het te belonen. En dus verandert er structureel niets—ook al heeft iedereen de beste intenties.

Wat de 5% anders doet

De organisaties die wél slagen delen drie dingen:

Ze wijzen eigenaarschap toe

Niet "iedereen doet mee", maar een concreet team: één expert die de inhoud kent, één ambassadeur die draagvlak bouwt, één engineer die technisch ondersteunt.

En cruciaal: iemand die de AI-agents "managed". Letterlijk. Die feedback ophaalt, prompts verbetert, en ervoor zorgt dat de output blijft matchen met de standaard van het team.

Ze beginnen bij processen, niet bij tools

Eerst uitzoeken: welke processen zijn gestandaardiseerd genoeg om te automatiseren? Waar zit variatie die menselijke beoordeling vraagt?

AI gedijt bij consistentie. Als tien mensen hetzelfde werk op tien verschillende manieren doen, kan AI niet leren wat "goed" is.

Ze behandelen AI als een nieuwe collega

Die je moet inwerken. Die feedback nodig heeft. Die pas na weken écht op niveau is—en alleen als iemand die begeleiding geeft.

Het klinkt soft, maar het is de kern: AI-implementatie lijkt meer op mensen opleiden dan op software installeren.

De les

AI-projecten falen niet door slechte technologie. Ze falen door dezelfde reden waarom reorganisaties falen: geen eigenaarschap, geen feedback loop, geen heldere definitie van succes.

De 95% behandelt AI als een tool die je installeert.

De 5% behandelt AI als een collega die je begeleidt.

Veelgestelde vragen

Hoeveel procent van AI-projecten mislukt?

Volgens MIT-onderzoek uit 2025 haalt 95% van AI-pilots nooit de productie met meetbare ROI. Slechts 5% bereikt het stadium waarin AI daadwerkelijk bijdraagt aan bedrijfsresultaten.

Wat is de learning gap bij AI?

De learning gap beschrijft het verschil tussen menselijk leervermogen en AI-stagnatie. Mensen verbeteren vanzelf door ervaring; AI-tools blijven exact hetzelfde presteren tenzij iemand actief feedback verzamelt en verbeteringen doorvoert.

Wat is de belangrijkste reden dat AI-implementatie faalt?

Niet technologie of budget, maar ontbrekend beleid. Organisaties definiëren niet wat goed AI-gebruik betekent, hoe je het meet, en hoe je het beloont. Daardoor blijft adoptie steken bij enthousiastelingen in plaats van een organisatiebrede werkwijze te worden.

Bronnen: MIT NANDA Report: The GenAI Divide 2025, Fortune: Why 95% of AI pilots fail