Blogs

Van AI-pilot naar productie: waarom opschaling bijna altijd een mensenprobleem is

De pilot werkt. De resultaten zijn goed. Het team is enthousiast.

En dan blijft het daar hangen.

Zes maanden later draait dezelfde pilot nog steeds met dezelfde vijf mensen. Opschaling? Komt eraan. Maar het gebeurt niet.

Het probleem is zelden technisch. Het is bijna altijd menselijk.

De menselijke kant wordt vergeten

Pilots beginnen met een paar enthousiastelingen. Mensen die nieuwsgierig zijn, die willen experimenteren, die de tool graag uitproberen.

Maar bij opschaling verandert alles.

Plotseling moeten tientallen mensen input leveren aan een AI-systeem. Output controleren. Hun werkwijze aanpassen. En dat wordt onderschat.

"Human in the loop" klinkt simpel. Maar op schaal betekent het: veel mensen die allemaal dezelfde kwaliteitsstandaard moeten hanteren. Dezelfde manier van controleren. Dezelfde bereidheid om feedback te geven.

Dat lukt alleen als je die mensen vanaf het begin meeneemt.

Een pilot die bleef steken

Een van onze eerste projecten bleef steken. De technologie werkte. De resultaten waren goed. Maar de gebruikers gebruikten de tool niet.

Waarom niet?

Ze waren het niet eens met de output. Niet omdat die objectief slecht was—maar omdat ze niet meegenomen waren in het bepalen van de standaard. Iedereen had z'n eigen beeld van wat "goede output" was. En dus maakte iedereen z'n eigen versie.

Het was geen technische blokkade. Het was een menselijke blokkade.

De enthousiastelingen hadden de standaard bepaald. De rest voelde zich gepasseerd. En een tool die mensen niet willen gebruiken, is geen tool.

Een pilot die wél schaalde

Bij een grote verzekeraar deden we het anders.

We begonnen ook met enthousiastelingen. Maar elke stap lieten we valideren door de grotere groep. Niet achteraf—tijdens het proces.

"Dit wordt de nieuwe standaard voor deze output. Wat vinden jullie? Wat missen we? Waar zitten de uitzonderingen?"

Toen we klaar waren om op te schalen, was iedereen al op de hoogte. Sterker: iedereen had meegebouwd aan de standaard. De voordelen waren vertaald naar hún voordelen. En mensen waren al overtuigd van de meerwaarde—inclusief het besef dat het niet perfect is, dat experimenteren nodig blijft, en dat hun feedback het alleen maar beter maakt.

Resultaat: brede adoptie vanaf dag één.

De 80/20 van edge cases

Technisch gezien kun je 80% van de gevallen snel automatiseren. De standaard documenten, de normale aanvragen, de voorspelbare input.

De uitdaging zit in de andere 20%. Of eigenlijk: de 10% die écht lastig is.

Gekke PDF's. Facturen met afwijkende layouts. Aanvragen die net even anders zijn. Een mens kan daar prima mee omgaan—die ziet direct wat er bedoeld wordt. Maar AI heeft het er lastig mee.

En hier zit de valkuil: pilots worden vaak gedaan met de "mooie" documenten. De voorbeelden die goed werken. Die 80%.

Pas bij opschaling kom je de edge cases tegen. En als je daar niet op voorbereid bent, daalt de kwaliteit en het vertrouwen.

Dus: test tijdens de pilot al met de moeilijke gevallen. Niet alleen de makkelijke.

Wie is eigenaar van opschaling?

Je hebt twee mensen nodig. Niet twee afdelingen—twee mensen met duidelijke rollen.

De enthousiasteling

Iemand die bezig is met de mensen. Die draagvlak bouwt, vragen beantwoordt, zorgen wegneemt. Die ervoor zorgt dat de grotere groep betrokken blijft.

De expert

Iemand die gezien wordt als inhoudelijk expert binnen de afdeling. Die bepaalt wat kwaliteit is. Die kan beoordelen of de output goed genoeg is.

Deze combinatie—mens én inhoud—is cruciaal. Eén iemand die alleen enthousiast is zonder inhoudelijke autoriteit krijgt geen draagvlak. Eén iemand die alleen expert is zonder people skills krijgt geen adoptie.

Samen zijn ze het aanspreekpunt. De "manager" van de AI-implementatie.

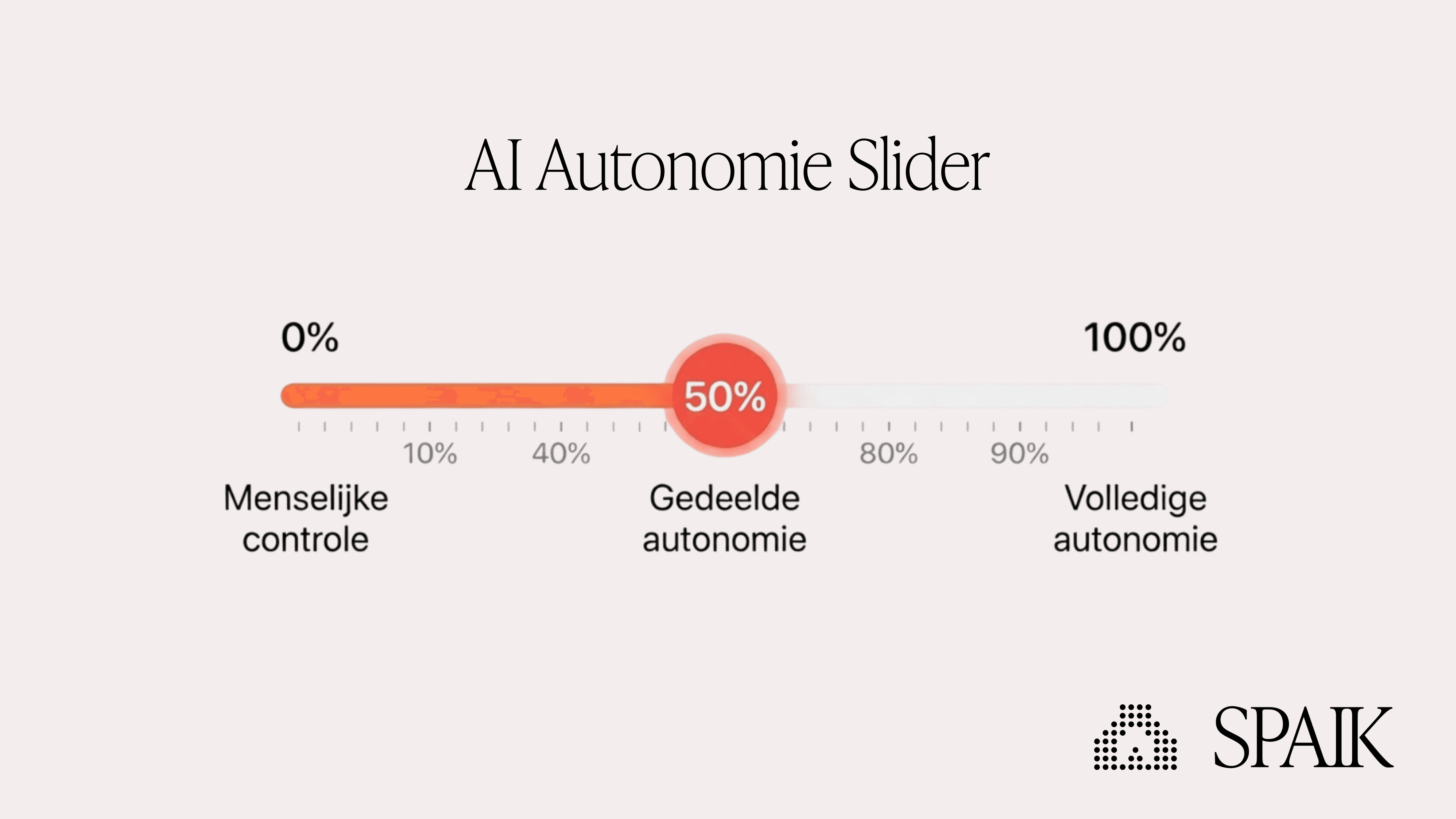

De autonomy slider: van 0% naar 97%

Denk aan AI-autonomie als een slider. Links: 0%, volledig menselijke controle. Rechts: 100%, volledige AI-autonomie.

Bij een pilot zit je ergens rond de 50%. Shared autonomy. AI doet het werk, mens controleert alles.

Om te kunnen opschalen moet je naar rechts. Niet naar 100%—dat is zelden realistisch of wenselijk. Maar naar 97%. Een punt waarop je vertrouwt dat AI het overgrote deel van de cases correct afhandelt.

Die sprong van 50% naar 97% is waar de meeste pilots stranden.

Want dat vertrouwen moet je verdienen. Door te testen. Door edge cases te vangen. Door te bewijzen dat de output consistent goed is.

En dan, na opschaling, werk je samen verder naar 99%. Niet door minder te controleren, maar door slimmer te controleren. Door te leren welke cases wél extra aandacht nodig hebben.

Kwaliteit behouden op schaal

Met 5 gebruikers kun je persoonlijk checken of de output goed is. Met 50 niet meer.

De oplossing: gebruikers leren om zelf de kwaliteit te checken.

Dat betekent dat je samen moet afspreken: wat ís kwaliteit? Wat is goed genoeg? Waar zitten de grenzen?

Dit gesprek moet je voeren vóórdat je opschaalt. Anders krijg je 50 mensen met 50 verschillende standaarden.

Je kunt een kwaliteitstoets automatiseren. Maar in het begin wil je die vooral menselijk houden. Zodat mensen leren wat ze moeten checken, en waarom.

"Human in the loop" wordt bij opschaling niet kleiner—hij wordt groter. Meer mensen die moeten controleren. Meer mensen die moeten begrijpen wat goed is. Tot je op dat 97% vertrouwensniveau zit—en samen verder bouwt naar 99%.

Wanneer is een pilot klaar om te schalen?

Drie signalen:

1. De output is consistent

Niet alleen bij de makkelijke gevallen, maar ook bij de edge cases. De pilot levert in veelvuldige situaties de juiste output.

2. De standaard is gedeeld

Iedereen die de tool gaat gebruiken weet wat kwaliteit is. En is het daarmee eens.

3. De eindgebruikers zijn op de hoogte

Geen verrassingen bij de uitrol. Mensen weten wat er komt, waarom, en wat het voor hen betekent.

Ontbreekt er één? Dan schaal je te vroeg.

Veelgestelde vragen

Hoe lang duurt de stap van pilot naar productie?

Gemiddeld 2-4 maanden, afhankelijk van hoeveel mensen je moet meenemen en hoe complex de edge cases zijn. Haast werkt averechts—te vroeg opschalen leidt tot weerstand.

Kunnen we de kwaliteitscontrole automatiseren?

Op termijn deels, maar begin menselijk. Mensen moeten eerst leren wat kwaliteit is voordat je dat kunt automatiseren. Anders automatiseer je de verkeerde standaard.

Wat als sommige mensen de tool niet willen gebruiken?

Vaak een signaal dat ze niet meegenomen zijn in het bepalen van de standaard. Ga terug, vraag hun input, en pas aan waar nodig. Dwang werkt niet.

Wie moet eigenaar zijn van de opschaling?

Een duo: iemand voor de mensen (draagvlak, communicatie) en iemand voor de inhoud (kwaliteit, standaard). Samen zijn ze het aanspreekpunt.

Opschaling is de lastigste stap. De AI Kickstart begeleidt je van pilot naar productie—inclusief het opzetten van eigenaarschap, kwaliteitsstandaarden, en draagvlak bij de bredere groep.

Bron: Harvard Business Review: Why Pilots Succeed and Scale-Ups Fail